Calidad del dato

#InformeLanaspa

Hace ya bastante tiempo recuerdo estar tomándome una cerveza con Jesús Barón, maestro internacional de ajedrez y uno de mis primeros jefes en mi vida profesional, y recuerdo estar hablando sobre la importancia de la calidad del dato.

Conversábamos sobre cómo muchos productos digitales hoy en día trabajan sobre bases de datos que contienen grandes cantidades de errores y lo poco que se trabaja y reflexiona al respecto.

Estamos muy acostumbrados a la importancia de poner en marcha organizaciones, productos y procesos data-driven.

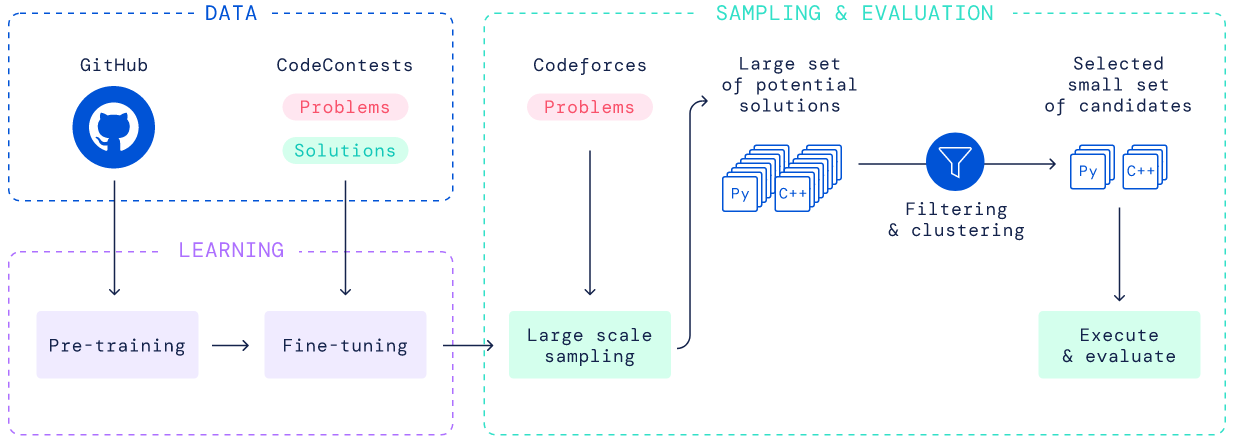

Estamos muy acostumbrados también a añadir una capa de IA sobre nuestro software para lograr resultados espectaculares en nuestro producto.

Sin embargo, he trabajado durante toda mi carrera en proyectos relacionados con datos y casi nunca he visto un mínimo interés por la calidad del dato utilizado. Es un tema aburrido y poco sexy. Revisar la calidad del dato de todos nuestros procesos es una tarea ardua y sin final.

GIGO

En inglés, GIGO (Garbage in, garbate out), es un concepto utilizado para explicar como el nivel de utilidad de cualquier pieza y producto software es proporcional al nivel de calidad de la información con la que se le alimenta.

Todo proceso industrial tiene sus procesos y sistemas de calidad que garantizan la creación de un producto seguro, fiable y útil.

En el mundo del software pasa algo parecido, tenemos interiorizado que todo software que se desarrolle debe de llevar siempre asociado una batería de pruebas que garantice su robustez y fiabilidad.

Sin embargo, si el producto digital es la combinación de un software y los datos con los que se le alimenta… ¿Por qué se dedica tanto esfuerzo a tener un software de calidad y no tanto a tener unos datos de calidad?

¿Tenemos incluso un proceso/departamento de calidad del dato en nuestra organización?

La calidad del dato es un gran problema sobre todo cuando trabajamos en un producto que trata de digitalizar una industria que no es digitalmente nativa.

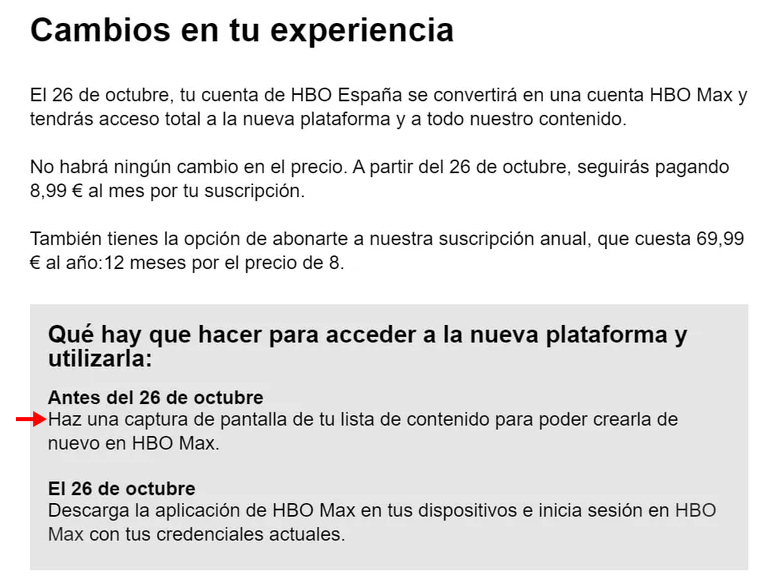

Siempre nos encontraremos información duplicada, outliers, información vacía o incompleta, datos corruptos, información desactualizada…

Y si trabajas con múltiples fuentes de datos este problema se agrava, ¿todas las fuentes de datos han seguido las mismas políticas, metodologías y principios de recolección de la información?

Cuando miramos a los presupuestos de las organizaciones de software, cada vez vemos más inversión en inteligencia artificial, pero ¿cuánta energía y recursos dedicamos a data science o a inteligencia artificial frente a la que dedicamos a mantener una calidad de dato mínima?

Todos sabemos que tener “malos” datos es muy caro. Si basamos nuestra toma de decisiones en datos, tener datos incorrectos puede resultar algo incluso extremadamente caro.

También sabemos que tener los mejores datos del mercado es una ventaja competitiva enorme.

Sin embargo, creo personalmente que existe una falta de inversión generalizada en mantener una calidad del dato mínima en la gran mayoría de organizaciones software.

Un test breve

Vamos a realizar un test breve para reflexionar cuanto sabemos sobre los datos en los que se basan nuestros productos. Este test es especialmente relevante si tu producto se basa en la utilización de datos, procesamiento de datos o IA:

- ¿Cuál es la calidad de dato mínima para operar tu producto? ¿Cómo la defines? ¿Cual es el nivel de calidad del dato a partir del cual tu producto empieza a dejar de aportar valor?

- ¿Cómo de precisa dirías que es la información con la que trabajas? ¿Cómo mides esa precisión? ¿Cuál es el nivel de precisión a partir del cual tu producto comienza a dejar de ser útil?

- ¿Cómo de completa es la información con la que trabajas? ¿Los datos con los que trabajas cubren todo el universo de información que querrías ofrecer en tu producto?

- ¿Cómo de consistente son los datos con los que trabajas? ¿Existen datos que no cuadran entre si? ¿Qué haces cuando esto ocurre?

- ¿Cómo de fiable son los datos con los que trabajas? ¿Están actualizados? ¿Cuánto ruido tienen? ¿Cómo defines si un dato es fiable o no lo es?

- Desde que añadiste la última fuente de datos, ¿tu producto ha mejorado su nivel de calidad del dato en alguna dimensión?¿Serías capaz de decirme cual es el nivel de error medio que tienen las distintas fuentes de datos a las que te estás conectando?

Si has sido capaz de responder con claridad a la mitad de estas preguntas y te sientes cómodo con los procesos que estás siguiendo para poder responder a cada una de ellas estás de enhorabuena, estás por encima de la media en gestionar la calidad del dato con el que trabajas.

Tiempo de reflexionar sobre la calidad del dato en las organizaciones y productos en los que trabajamos.